Secciones

Servicios

Destacamos

Javier Guillenea

Martes, 12 de diciembre 2017, 07:27

Un dron que cabe en la palma de una mano comienza a volar sin que nadie lo guíe a distancia. Gracias a un programa ... de reconocimiento facial, no tendrá problemas en identificar a su objetivo entre muchas otras personas. Se acercará silenciosamente hasta él y se posará sobre su frente con una carga explosiva de tres gramos en su interior. La explosión destrozará el cerebro de su víctima. ¿Y si en vez de uno son muchos? Una furgoneta aparca cerca del lugar donde se desarrolla un importante acto institucional. De su interior surge un enjambre de drones asesinos, cada uno con el rostro de un dirigente político en su memoria. Una vez sueltos, ya no habrá marcha atrás. Los robots han sido 'entrenados' para esquivar los manotazos de sus objetivos. Son autónomos y tercos como mulas, no se detendrán hasta posarse en una frente. Al menos oficialmente, estos drones aún no existen, pero la tecnología para fabricarlos hace mucho que está disponible. Además, es barata. La idea de que alguien lance al aire una flotilla de minúsculos y letales robots dispuestos a morir matando es real, como también lo es un futuro no demasiado lejano en el que la guerra quede en manos de las máquinas.

Lo que dijo en la ONU el pasado día 13 el embajador de la India, Amandeep Gill, fue una broma de esas que se sueltan en los discursos para romper el hielo, pero quizá llegue la hora en la que alguien la repita en serio. «Damas y caballeros, tengo noticias para ustedes: los robots no están tomando el mundo. Los humanos siguen al mando», reveló el embajador a los miembros del grupo de expertos gubernamentales sobre sistemas de armas autónomas letales que durante una semana se han dado cita en Ginebra para hablar por primera vez sobre los retos e implicaciones éticas, técnicas, militares y legales de lo que unos llaman sistemas armamentísticos autónomos letales y otros, simplemente, robots asesinos.

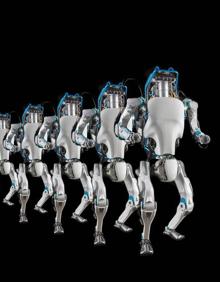

Atlas. Desde su creación, en 2013, este robot ha experimentado una enorme evolución. Ya es capaz de dar volteretas hacia atrás sin problemas.Puede ser el soldado del futuro.

BigDog. Mide 91 cm de largo y 76 de alto. Es capaz de transportar 181 kilos de carga por terrenos difíciles. Ha sido superado por otros modelos.

Wildcat. Puede alcanzar hasta 25 kilómetros por hora en superficies planas. Su punto débil es el ruido que hace su motor.

Kalashnikov. La empresa rusa ha anunciado que ya cuenta con tanques capaces de funcionar con inteligencia artificial, sin que haga falta una mano humana para que actúen.

Enjambres. Construir un pequeño aparato volador que cabe en una mano y lleva dentro un explosivo es algo que ya está al alcance de demasiadas personas.

SGR-A1. Aunque en teoría depende de un humano, se cree que puede actuar por su cuenta y disparar a intrusos. Corea del Sur lo tiene desplegado en su frontera.

La reunión fue el fruto de la creciente alarma mostrada por científicos e investigadores de todo el mundo, que han comenzado a lanzar advertencias sobre los riesgos de la aplicación de la inteligencia artificial (IA) a la guerra. El pasado mes de agosto, 137 especialistas o fundadores de empresas de IA enviaron una carta a la ONU en la que alertaban del «peligro potencial de las armas letales autónomas». En la misiva reclamaban una urgente regulación de las máquinas capaces de matar sin control humano.

Todavía no existen, pero ideas hay muchas. En 1958 nació en Estados Unidos la Agencia de Proyectos de Investigación Avanzados de Defensa (Darpa), que desde entonces no ha parado de pergeñar nuevas formas de hacer guerras más eficaces. En sus laboratorios se experimentan todo tipo de propuestas, por muy disparatadas que parezcan, y quizá por esa apertura de miras sus logros han sido notables. De la agencia ha surgido internet, el ratón de ordenador y el GPS, entre otras muchas tecnologías.

En Darpa se investigan actualmente prótesis para soldados heridos, implantes cerebrales para acabar con el estrés postraumático de los combatientes, balas capaces de variar de trayectoria, exoesqueletos, propulsores para correr más deprisa, uniformes que curan heridas y barcos que navegan sin tripulación. También diseñan robots como 'Atlas', un humanoide de 1,80 metros de altura capaz de dar una voltereta hacia atrás, o 'WildCat' y 'BigDog', dos robots de cuatro patas ideados para transportar cargas pesadas a través de todo tipo de terreno. En principio, la tarea de 'Atlas' será la de ayudar en servicios de emergencia, pero no se descarta que alguna vez le llegue el momento de su bautismo de fuego. En cuanto a sus hermanos cuadrúpedos, algunos ya han entrado en combate como 'bestias de carga', aunque el excesivo ruido de su motor los hace poco eficientes y el proyecto ha quedado aparcado, a la espera de tecnologías mejores.

En Rusia, la compañía Kalashnikov ha desarrollado un robot de combate dotado de inteligencia artificial, capaz de decidir cuándo atacar y a quién disparar. El aparato, una especie de caja sobre ruedas con ametralladoras, no es una maravilla del diseño y existen dudas sobre su efectividad, pero anticipa lo que tarde o temprano llegará.

Todos los gobiernos lo saben y, al menos los que tienen capacidad tecnológica, se han embarcado en una carrera para convertir la guerra en una cuestión de máquinas. Se han construido tanques robotizados, camiones, aviones y buques no tripulados, se teoriza sobre robots soldados y, sobre todo, se desarrolla la inteligencia artificial con el objetivo más o menos confeso de crear armas autónomas capaces de actuar sin intervención humana. Serían ellas las que, en última instancia, decidieran cuándo matar a una persona.

«Creo que debemos tomar conciencia de que los sistemas de armas autónomas letales suponen una revolución transformadora que puede situarnos en un riesgo existencial notable», previene el filósofo y experto en ética robótica Aníbal Monasterio, investigador del centro de ética práctica Uehiro de la Universidad de Oxford. Es una revolución que comienza con una pregunta: ¿se puede delegar en una máquina la capacidad de matar?

«Esta posibilidad es indigna», responde el director del Instituto de Investigación en Inteligencia Artificial del CSIC, Ramón López de Mántaras, uno de los 137 firmantes de la carta enviada a la ONU. A su juicio, conceder a un robot autonomía absoluta para decidir cuándo y a quién atacar traería consigo una «proliferación de conflictos armados y un incremento de víctimas civiles».

Frente a quienes sostienen que las armas autónomas salvarían la vida de muchos soldados, López de Mántaras recuerda que «las protestas contra la guerra de Vietnam se desataron cuando empezaron a llegar a Estados Unidos ataúdes de combatientes muertos». Las batallas entre robots evitarían bajas de militares pero, por el contrario, «causarían más daños colaterales; morirían más civiles que ahora». «Si fuera verdad que no hay féretros con soldados bajaría la presión social y a los gobernantes les sería más fácil provocar conflictos armados», argumenta el investigador del CSIC.

Y les sería mucho más sencillo matar. «Las principales potencias militares ya están trabajando en sistemas de armas donde no será necesaria la supervisión humana. Este es un gran problema ético y legal porque realmente sí que puede crear la mentalidad de 'playstation' en los militares -afirma Aníbal Monasterio-. La guerra se banaliza y se convierte en un juego de ordenador, donde dar un 'click' es lo único que requiere la batalla, perdiendo de vista la tragedia que se crea».

También se perdería el concepto de responsabilidad. Porque si un robot provocara por su cuenta una masacre, ¿a quién se le echaría la culpa? «A nadie, porque el robot es autónomo; lo único que tú has hecho es un algoritmo», contesta Juan Julián Merelo, catedrático de Arquitectura y Tecnología de Computadores de la Universidad de Granada. «La pregunta que surge es a quién debemos culpar: al robot, a la empresa que lo ensambló, al ingeniero que lo diseñó, al científico computacional que lo programó o al filósofo que asesoró su construcción en materia de calidad y ética. Nuestras normativas y regulaciones -señala Aníbal Monasterio- tendrán que analizar esta problemática».

Uno de los escollos de una hipotética guerra con máquinas autónomas es la dificultad con la que se toparían los robots a la hora de distinguir entre un amigo o un enemigo, sobre todo en un contexto como el actual, en el que soldados y civiles están mezclados. «Para una máquina es imposible discrminar entre militares y civiles o saber si un combatiente que alza las manos se está rindiendo o no», puntualiza López de Mántaras. Si un algoritmo dice que tienen que morir, morirán.

José María Navarro, periodista de la revista 'Defensa', no piensa que se vaya a llegar a tanto. «No creo que los robots lleguen a tomar decisiones por su cuenta», indica. «Los propios militares -añade- no quieren que las armas sean autónomas porque los mandos van a querer decidir si atacan o no». Juan Julián Merelo es de la misma opinión. Recuerda que «ni siquiera los soldados que manejan un dron pueden decidir si disparan o no porque existe una cadena de mando», pero advierte de que «puede haber algún grupo terrorista o de mercenarios» que no piensen lo mismo y no tengan escrúpulos a la hora de utilizar armas autónomas.

Stop Killer Robots. En abril de 2013, una veintena de ONG puso en marcha en Londres una campaña para reclamar a los gobiernos la prohibición de los sistemas de armas plenamente autónomos. Según estas organizaciones, países como China, Rusia, Reino Unido, Corea del Sur, Israel y, en especial, Estados Unidos están invirtiendo mucho dinero para que estos autómatas para la guerra sean una realidad. Los defensores de este tipo de sistemas sostienen que los robots soldado, los tanques no tripulados y los aviones autónomos permitirán salvar muchas vidas en los campos de batalla y entre la población civil, porque responderán a las acciones de guerra con más precisión.

137. especialistas en inteligencia artificial firmaron el pasado mes de agosto una carta en la que alertan sobre «el peligro potencial de las armas letales autónomas» y piden una urgente regulación de este tipo de máquinas para impedir que sean capaces de matar sin ningún control humano. Consideran indigno delegar esta capacidad en un robot.

A favor. Mark Zuckerberg, fundador de Facebook, no comparte la visión pesimista de quienes advierten de los riesgos de la inteligencia artificial. A su juicio, a medida que la IA siga desarrollándose, la tecnología llevará a la humanidad a un futuro más seguro y a «una mejora increíble en la vida de la gente». Para Zuckerberg, argumentar lo contrario es «bastante irresponsable».

La Tercera Guerra Mundial. El director ejecutivo de Tesla Motors y SpaceX, Elon Musk, ha advertido recientemente de que la competencia entre los países por hacerse con el liderazgo en el ámbito de la inteligencia artificial podría convertirse en la causa de desencadenamiento de la Tercera Guerra Mundial. Según Musk, en este caso no serán los líderes planetarios quienes desaten el fatal conflicto, sino «una de las inteligencias artificiales, en el caso de que esta decida que un ataque preventivo es el camino más probable hacia la victoria». El pasado mes de noviembre, el científico Stephen Hawking aseguró en Lisboa que el uso negligente de tecnología de inteligencia artificial aplicada a la guerra «implica serios peligros, como el desarrollo de poderosas armas autónomas».

El pasado mes de junio, investigadores de Facebook tuvieron que desconectar dos robots que habían desarrollado entre ellos un lenguaje propio mientras les estaban 'enseñando' a negociar y a mejorar sus habilidades de diálogo. Gracias a la IA, las máquinas pueden experimentar y aprender por su cuenta para ser más eficaces en lo suyo, incluida la guerra. «Si ven que a la primera no han conseguido su objetivo, a la próxima lo harán de otra manera», explica Samuel Álvarez, director general del Grupo In-Nova y coordinador del máster de Tecnologías para la Defensa de la Politécnica de Madrid, quien pone el acento en «la amenaza de que en un futuro no muy lejano el hombre pierda el control».

Una de las posibles consecuencias de esta pérdida es inquietantemente extrema. Puede darse el caso de que las máquinas entrenadas para hacer la guerra por su cuenta sigan combatiendo entre ellas aun cuando el conflicto haya terminado. «Este es uno de los escenarios distópicos plausibles, sistemas de armas autónomas letales podrían entrar en combate en un bucle continuo que puede conducir a un riesgo existencial global», dice Aníbal Monasterio. Parece imposible, pero no se descarta. «Si una máquina aprende a ser letal y a mantenerse por su cuenta -advierte Samuel Álvarez-, la sociedad correrá un riesgo enorme».

En abril de 2013, una veintena de ONG puso en marcha en Londres una campaña para reclamar a los gobiernos la prohibición de los sistemas de armas plenamente autónomos. Según estas organizaciones, países como China, Rusia, Reino Unido, Corea del Sur, Israel y, en especial, Estados Unidos están invirtiendo mucho dinero para que estos autómatas para la guerra sean una realidad. Los defensores de este tipo de sistemas sostienen que los robots soldado, los tanques no tripulados y los aviones autónomos permitirán salvar muchas vidas en los campos de batalla y entre la población civil, porque responderán a las acciones de guerra con más precisión.

¿Ya eres suscriptor/a? Inicia sesión

Publicidad

Publicidad

Te puede interesar

Publicidad

Publicidad

Esta funcionalidad es exclusiva para suscriptores.

Reporta un error en esta noticia

Comentar es una ventaja exclusiva para suscriptores

¿Ya eres suscriptor?

Inicia sesiónNecesitas ser suscriptor para poder votar.